2024 하계 모각코 회고

회고 처음에 인공지능에 관한 논문을 찾아보며 공부를 하기로 계획 했지만 아직 이 분야에 대한 지식이 많이 부족해 논문을 보며 완전한 이해는 아니더라도 얻어갈 수 있는 것이 있을지, 논문을 어떤 식으로 읽어가야 하는지에 대해 걱정을 많이 했다. 물론 처음에는 막막했지만 계속해서 ...

Challenge1) SAR segmentation (7.18 발표)

Goal : (precision:90 recall:80 || F1score:87) && 연산량 GFlops=0.5 (FLOPS = 속도(GPU), FLOPs = 양(모델))

논문 리뷰 1/2~3days(2Q per 1 + 아이디어 도출)

오마카세 : 1/2week 화(7pm) - start(7.2)

논문리뷰 : 매주 월/수(2pm)(발표날에는 생략) + 이때 질문하면서 논문 쓸 주제 생각해보기(~7.31)

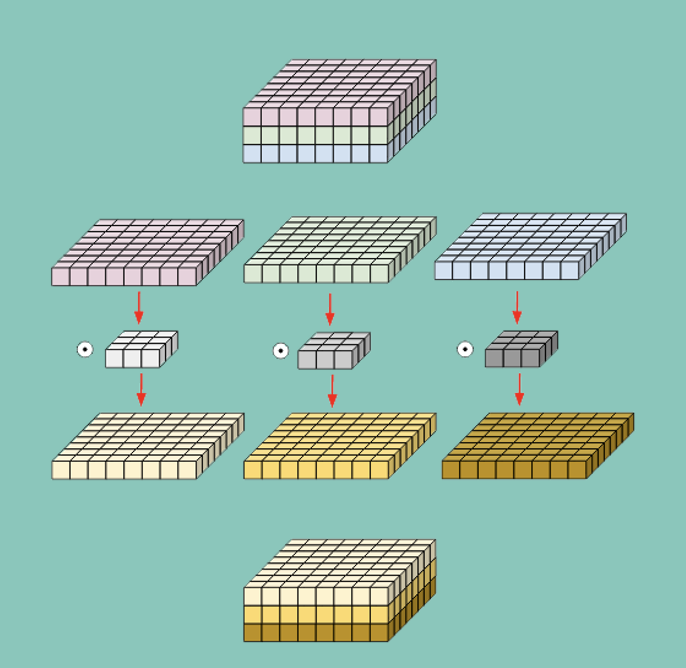

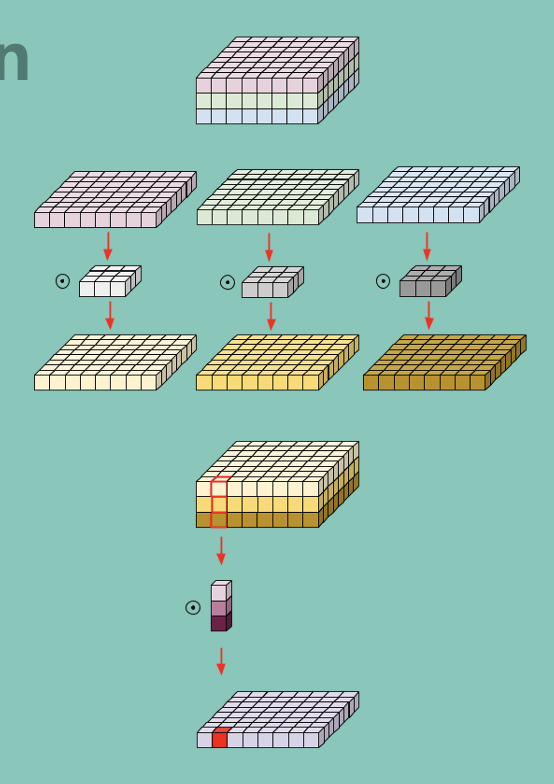

너비,깊이 나눠서 연산

병목현상 : 정보가 몰릴 때 중요한 정보만 통과시키는 것을 뜻함.

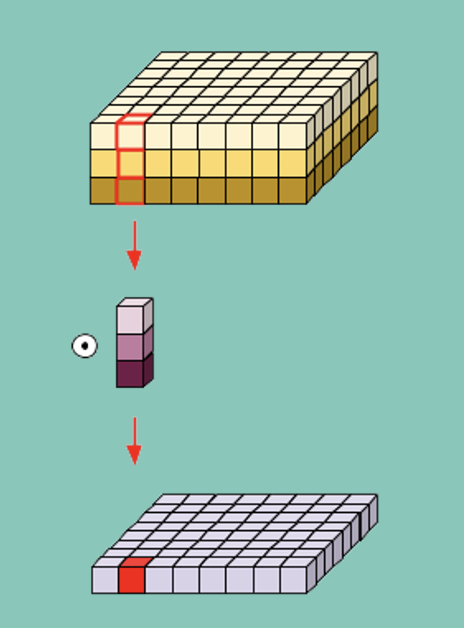

<inverted bottleneck>

배경 : 기존 bottleneck 은 Relu로 인해 중요한 정보가 소실되는 문제가 있음

그래서 반대로 확장시켜 Relu를 사용해도 중요한 정보 손실이 나지 않고 non-linearity를 유지할 수 있게할 방법을 생각하게 됨 → “Inverted bottleneck”

동작 방식 : 128 → 512 → 256 → 128(128~256) 이런 식으로 기존의 bottleneck과 달리 모든 정보를 거의 다 볼 수 있어 정보 손실이 줄어듦

문제점 : 연산량이 많아진다는 단점이 존재 → mobileNetV1 에서 사용된 Depth-wise Separable Convolution(Depth-wise + point-wise)을 통해 연산량을 줄여줌

NAS(Neural Architecture Search) : 신경망의 구조를 자동으로 설계하는 기술로, 최적의 신경망 아키텍처를 찾기 위해 기계 학습 기법을 사용

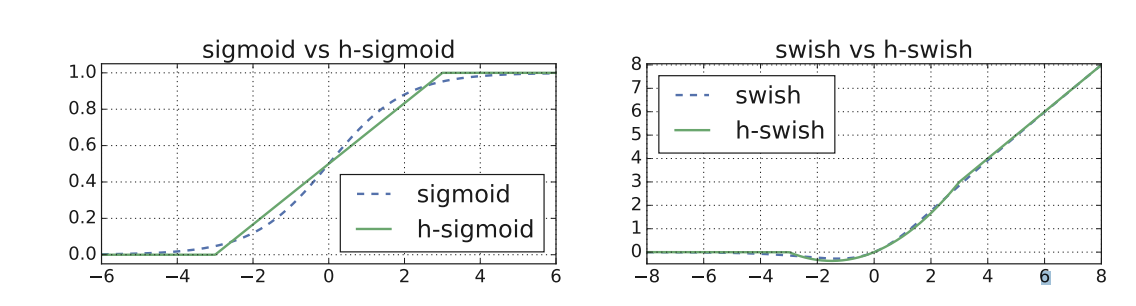

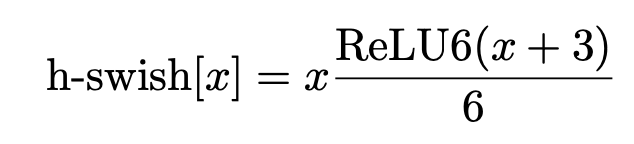

swish : 음수 값이여도 갱생의 기회를 줌

hswish: swish 에서 e^x 계산이 복잡해져서 보완하기 위해 나옴

MobileNetV3 정리 ⇒ NAS 를 통해 모델 구조를 뽑아내고 hard-swish를 적용시켜 성능을 향상시킨 모델

회고 처음에 인공지능에 관한 논문을 찾아보며 공부를 하기로 계획 했지만 아직 이 분야에 대한 지식이 많이 부족해 논문을 보며 완전한 이해는 아니더라도 얻어갈 수 있는 것이 있을지, 논문을 어떤 식으로 읽어가야 하는지에 대해 걱정을 많이 했다. 물론 처음에는 막막했지만 계속해서 ...

논문 리뷰

논문 리뷰

논문 리뷰

논문 리뷰

논문 리뷰

논문 리뷰

계획 Challenge1) SAR segmentation (7.18 발표)